O Google não tem o melhor histórico quando se trata de inteligência artificial geradora de imagens.

Em fevereiro, o gerador de imagens integrado ao Gemini, o chatbot AI do Google, foi encontrado aleatoriamente injetando diversidade de gênero e racial em prompts sobre pessoas, resultando em imagens de nazistas racialmente diversos, entre outras imprecisões ofensivas.

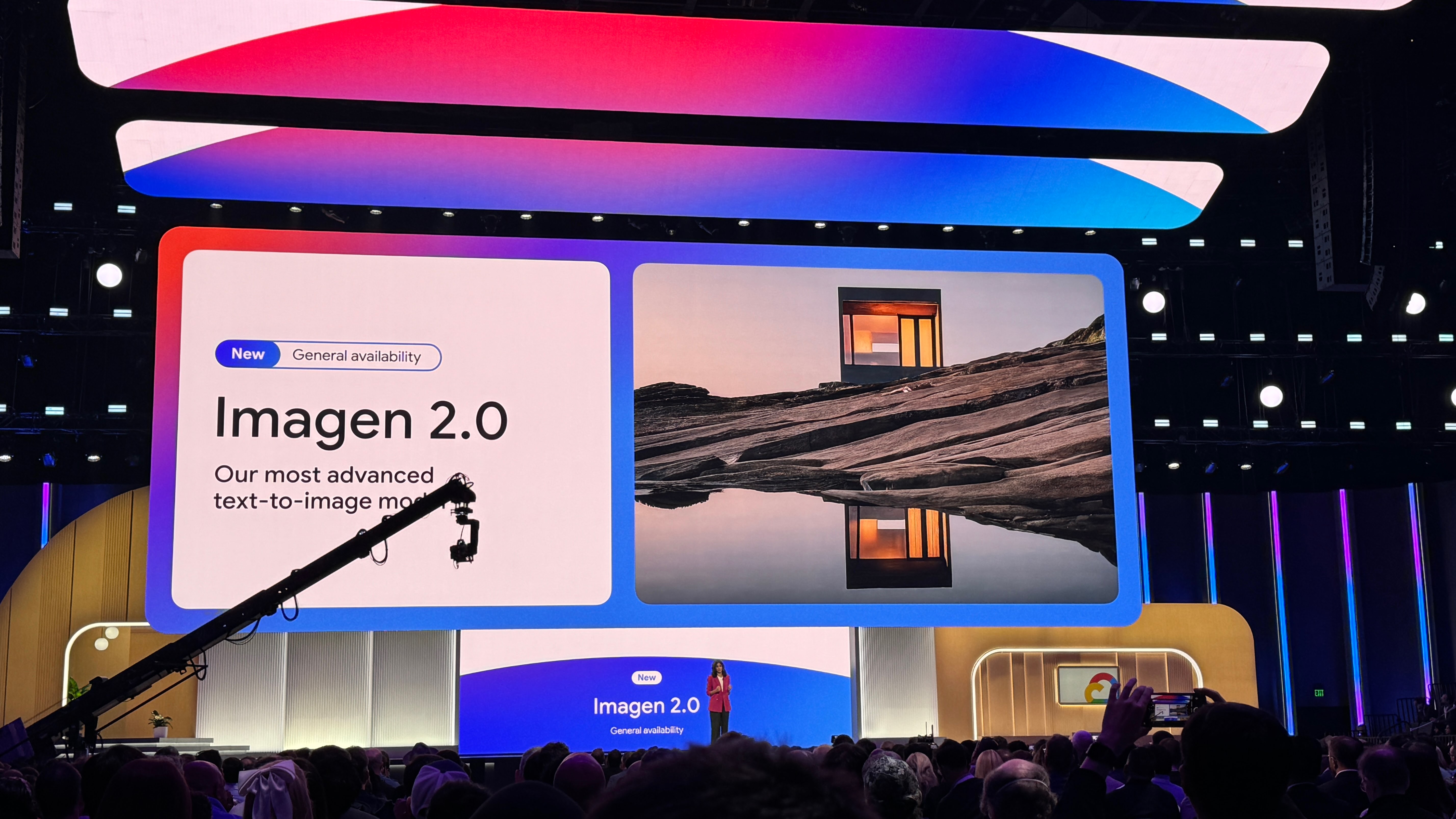

O Google retirou o gerador, prometendo melhorá-lo e eventualmente relançá-lo. Enquanto aguardamos seu retorno, a empresa está lançando uma ferramenta aprimorada de geração de imagens, Imagen 2, dentro de sua plataforma de desenvolvimento Vertex AI - embora seja uma ferramenta com um foco decididamente mais empresarial.

Imagen 2 - que na verdade é uma família de modelos, lançada em dezembro após ser apresentada na conferência I/O do Google em maio de 2023 - pode criar e editar imagens a partir de uma simples descrição de texto, assim como o DALL-E e o Midjourney da OpenAI. De interesse para empresários, o Imagen 2 pode renderizar texto, emblemas e logotipos em vários idiomas, sobrepondo esses elementos em imagens existentes - por exemplo, em cartões de visita, vestuário e produtos.

O Google estreia o Imagen 2 com geração de texto e logotipo

Depois de ser lançado em versão de pré-visualização, a edição de imagens com o Imagen 2 agora está disponível no Vertex AI juntamente com duas novas capacidades: inpainting e outpainting. O inpainting e outpainting, recursos presentes em outros geradores populares de imagens como DALL-E, podem ser usados para remover partes indesejadas de uma imagem, adicionar novos componentes e expandir as bordas de uma imagem para criar um campo de visão mais amplo.

Mas o verdadeiro destaque do upgrade do Imagen 2 é o que o Google chama de "texto para imagens em movimento".

O Imagen 2 agora pode criar vídeos curtos de quatro segundos a partir de descrições de texto, seguindo a linha de ferramentas de geração de clipes de IA como o Runway, Pika e Irreverent Labs. Fiel ao foco corporativo do Imagen 2, o Google apresenta imagens em movimento como uma ferramenta para profissionais de marketing e criativos, como um gerador de GIFs para anúncios mostrando natureza, comida e animais - temas nos quais o Imagen 2 foi ajustado.

O Google diz que as imagens em movimento podem capturar "uma variedade de ângulos de câmera e movimentos", ao mesmo tempo que "suportam consistência durante toda a sequência." Porém, por enquanto elas estão em baixa resolução: 360 pixels por 640 pixels. O Google promete que isso vai melhorar no futuro.

Para amenizar (ou pelo menos tentar amenizar) preocupações em torno da possibilidade de criar deepfakes, o Google diz que o Imagen 2 utilizará o SynthID, uma abordagem desenvolvida pelo Google DeepMind, para aplicar marcas d'água criptográficas invisíveis nas imagens em movimento. Claro, detectar essas marcas d'água - que o Google afirma serem resistentes a edições, incluindo compressão, filtros e ajustes de tonalidade de cor - requer uma ferramenta fornecida pelo Google que não está disponível para terceiros.

E sem dúvida ansioso para evitar outra controvérsia envolvendo mídia generativa, o Google está enfatizando que a geração de imagens em movimento será "filtrada para segurança". Um porta-voz informou ao TechCrunch por e-mail: "O modelo Imagen 2 no Vertex AI não teve os mesmos problemas que o aplicativo Gemini. Continuamos a testar extensivamente e a nos envolver com nossos clientes."

Mas assumindo generosamente que a tecnologia de marca d'água, as mitigações de vies e os filtros do Google sejam tão eficazes quanto afirmam, as imagens em movimento são realmente competitivas com as ferramentas de geração de vídeo já disponíveis?

Não realmente.

O Runway pode gerar clipes de 18 segundos em resoluções muito mais altas. A ferramenta de clipes de vídeo da Stability AI, Stable Video Diffusion, oferece maior customizabilidade (em termos de taxa de quadros). E o Sora da OpenAI - que, concedido, ainda não está disponível comercialmente - parece estar pronto para superar a concorrência com o fotorrealismo que pode alcançar.

Então, quais são as verdadeiras vantagens técnicas das imagens em movimento? Não tenho certeza. E não acho que esteja sendo muito crítico.

Afinal, o Google está por trás de tecnologias de geração de vídeo genuinamente impressionantes como o Imagen Video e o Phenaki. O Phenaki, um dos experimentos mais interessantes do Google em texto para vídeo, transforma descrições longas e detalhadas em "filmes" de mais de dois minutos - com a ressalva de que os clipes são de baixa resolução, baixa taxa de quadros e apenas um tanto coerentes.

Diante de relatos recentes sugerindo que a revolução da IA generativa pegou o CEO do Google, Sundar Pichai, de surpresa e que a empresa ainda está lutando para acompanhar os concorrentes, não é surpreendente que um produto como imagens em movimento pareça um "também-ran". Mas é decepcionante mesmo assim. Não consigo evitar a sensação de que há - ou houve - um produto mais impressionante escondido nos laboratórios secretos do Google.

Modelos como o Imagen são treinados em um número enorme de exemplos geralmente obtidos de sites públicos e conjuntos de dados na web. Muitos fornecedores de IA generativa veem os dados de treinamento como uma vantagem competitiva e, portanto, mantêm esses dados e informações relacionadas próximos ao peito. No entanto, detalhes dos dados de treinamento também são uma fonte potencial de processos judiciais relacionados a propriedade intelectual, outro desincentivo para revelar muita informação.

Perguntei, como sempre faço em torno de anúncios relacionados a modelos de IA generativa, sobre os dados usados para treinar o Imagen 2 atualizado e se os criadores cujo trabalho pode ter sido incluído no processo de treinamento poderão optar por sair em algum momento futuro.

O Google me disse apenas que seus modelos são treinados "primariamente" com dados públicos da web, retirados de "postagens em blogs, transcrições de mídia e fóruns de conversação públicos." Quais blogs, transcrições e fóruns? Só podemos especular.

Um porta-voz apontou para os controles de publicação na web do Google que permitem que os webmasters impeçam a empresa de obter dados, incluindo fotos e obras de arte, de seus sites. Mas o Google não se comprometeu em lançar uma ferramenta de exclusão ou, alternativamente, compensar os criadores por suas contribuições (sem saber) - um passo que muitos de seus concorrentes, incluindo OpenAI, Stability AI e Adobe, tomaram.

Outro ponto que vale a pena mencionar: As imagens de texto em movimento não estão cobertas pela política de indenização de IA generativa do Google, que protege os clientes do Vertex AI de reivindicações de direitos autorais relacionadas ao uso de dados de treinamento pelo Google e saídas de seus modelos de IA generativa. Isso porque as imagens de texto em movimento estão tecnicamente em pré-visualização; a política só cobre produtos de IA generativa em disponibilidade geral (GA).

A regurgitação, ou quando um modelo generativo cospe uma cópia espelhada de um exemplo (por exemplo, uma imagem) pelo qual foi treinado, é legitimamente uma preocupação para os clientes corporativos. Estudos informais e acadêmicos mostraram que o Imagen de primeira geração não estava imune a isso, cospe imagens identificáveis de pessoas, obras protegidas por direitos autorais de artistas e mais quando solicitado de formas específicas.

Exceto por controvérsias, problemas técnicos ou algum outro contratempo importante não previsto, as imagens em movimento entrarão em GA em algum momento. Mas com as imagens em movimento conforme existe hoje, o Google está basicamente dizendo: use por sua conta e risco.